Технологическая компания OpenAI выпустила Whisper, инструмент для транскрипции на основе искусственного интеллекта, который выделяется своей "надежностью и точностью, близкой к человеческому уровню". Несмотря на эту похвалу, многие инженеры, разработчики и исследователи обнаружили серьезную проблему в Whisper: он часто выдумывает фрагменты текста или даже целые фразы.

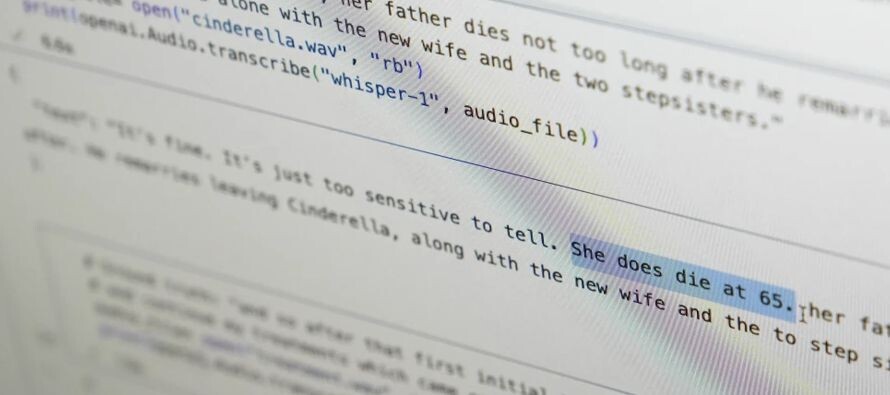

По собранным свидетельствам, некоторые транскрипции, созданные Whisper, включают галлюцинации, которые могут быть довольно неточными и в некоторых случаях даже тревожными. Один инженер по машинному обучению OpenAI отметил, что сбои сохраняются даже при тестах с хорошо записанным аудио, в то время как третий разработчик заявил, что обнаружил ошибки почти во всех 26,000 транскрипциях, которые он выполнил с помощью Whisper.

Несмотря на проблемы, Whisper стал чрезвычайно популярным и интегрируется в различные платформы, от колл-центров до голосовых помощников. Однако некоторые исследователи обнаружили заметные ошибки в его работе. Например, в исследовании, проведенном преподавателями Корнеллского университета и Университета Вирджинии, были найдены расистские комментарии, выдуманные Whisper в некоторых транскрипциях.

Несмотря на эти предупреждения, многие больницы и медицинские центры используют инструменты вроде Whisper для транскрипции медицинских консультаций, полагая, что медицинскому персоналу будет меньше времени требоваться на административные задачи. Хотя некоторые компании утверждают, что знают о галлюцинациях Whisper и пытаются решить проблему, остаются опасения по поводу точности и конфиденциальности транскрипций, созданных искусственным интеллектом.

Из-за конфиденциального характера медицинских взаимодействий законодатели и эксперты выразили свои опасения по поводу использования таких инструментов, как Whisper, в высокие рискованные среды. Некоторые исследователи нашли галлюцинации в большинстве проверенных транскрипций, что может иметь серьезные последствия, особенно в области здравоохранения.

Распространенность галлюцинаций в таких инструментах, как Whisper, привела к призывам к OpenAI решить эти проблемы и улучшить точность своих моделей искусственного интеллекта. Несмотря на последствия, которые могут иметь ошибки транскрипции, некоторые уверены, что при надлежащих корректировках эти проблемы могли бы быть решены.